Sadorimatsu

Проверенные

- Сообщения

- 383

- Решения

- 13

- Реакции

- 208

- Баллы

- 345

artscripts, а у вас при удалении с XF, файлы с облако так же удаляются? Вы проверяли? Просто есть у меня подозрение, почему у меня не удаляется. Вы какие роли прописывали в сервисом аккаунте? Я прописал только editor и на всякий случай admin т.к. толком нет понимания, какие роли прописывать. Подозреваю, что это влияет. Что думаете?

Пробовал настраивать ACL бакета, тоже толку никакого.

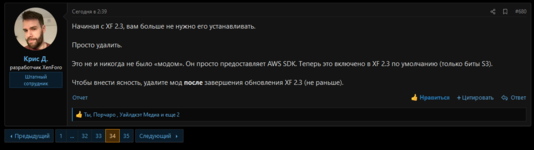

Можно не отвечать, Крис подтвердил на офе, что удаляется спустя некоторое время:

Так же на офе говорят, что data должен быть в любом плане публичным, а вот internal_data личным. Я не до конца понял как это сделать на яндексе. Есть соображения где? Да и пишут, что это необязательно, но всё же. Единственное, что настраивается доступ, это в политике доступа.

Настройки ACL можно даже не смотреть, он как понял применяется между несколько юзерами по доступу к этому бакету, может ошибаюсь, поправьте.

Пробовал настраивать ACL бакета, тоже толку никакого.

Можно не отвечать, Крис подтвердил на офе, что удаляется спустя некоторое время:

Лично подтвердил, так и есть. Так что с уверенностью можно сказать, что работает всё отлично. Но мне покоя не дает разница между путямиThey are deleted by cron job. For attachments you have just uploaded and deleted the files will remain on the server for up to 24 hours. For older attachments you have just deleted the files will remain on the server for up to 1 hour.

Так же на офе говорят, что data должен быть в любом плане публичным, а вот internal_data личным. Я не до конца понял как это сделать на яндексе. Есть соображения где? Да и пишут, что это необязательно, но всё же. Единственное, что настраивается доступ, это в политике доступа.

Настройки ACL можно даже не смотреть, он как понял применяется между несколько юзерами по доступу к этому бакету, может ошибаюсь, поправьте.

Последнее редактирование: