Sadorimatsu

Проверенные

- Сообщения

- 668

- Решения

- 22

- Реакции

- 450

- Баллы

- 1,775

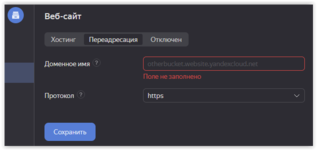

artscripts, про политику читал, не исключаю, что не все открыто и стоит по дефолту. Разрешение я давал тока на загрузку публичную по всему. Так что это отдельно надо проверять. Доменное имя прописал, скрин выше показал, тупо прописываю получается тока доменное имя и указываю нужный мне протокол https. Сами папки я не переносил ещё, я так понимаю нужно для этого применить

Жаль нет внятной инструкции по настройке, приходится методом тыка проверять.

У Вас недостаточно прав для просмотра ссылок.

Вход или Регистрация

, что в описании ниже, пока не пробовал. Но раз указали, что руками это лучше не делать, то хорошо, что не стал пробоватьЖаль нет внятной инструкции по настройке, приходится методом тыка проверять.

Последнее редактирование: